イントロダクション

今回の記事は私がnizimaやBOOTHで販売開始したLive2Dモデルの基本的な導入方法や調整方法とかを記述していこうと思います。

※PC版のWindows用のVTube Studioで使用する方法となりますので、御了承下さい。

多分、よほど特殊な構造じゃない限りはnizimaやBOOTHで購入された他のモデルでも、VTube Studio対応品なら大体同じ方法で使えると思いますので、参考程度に見ていって下さいませ。

宜しくお願い致します。

VTube Studioの導入

VTube Studioをインストールしていないという方はそちらの導入を最初に行う必要があります。

ただ、こちらをブログ内で詳しく説明すると非常に長くなってしまいますので、今回は丁寧に解説している他の方の動画を貼っておきますので、そちらの方を参考にしてインストールして下さいませ。

多分、Steamのアカウント作成を含めて10分かそこらくらいでいけるんじゃないかと思います。

↑Steamのアカウント作成~VTube Studioの起動までを非常に詳しく解説しておられますので、こちらを見ながらやって頂ければ、特に迷う事なくインストールまで出来ると思います。

SteamのVTube Studioのダウンロードはこちらからどうぞ。

購入したLive2DモデルをVTube Studioで使用する方法

では、まずはVTube Studioを起動しましょう。

↑通常インストールした場合、デスクトップ画面にこういうアイコンが生成されていると思いますので、ダブルクリックして起動して下さい。

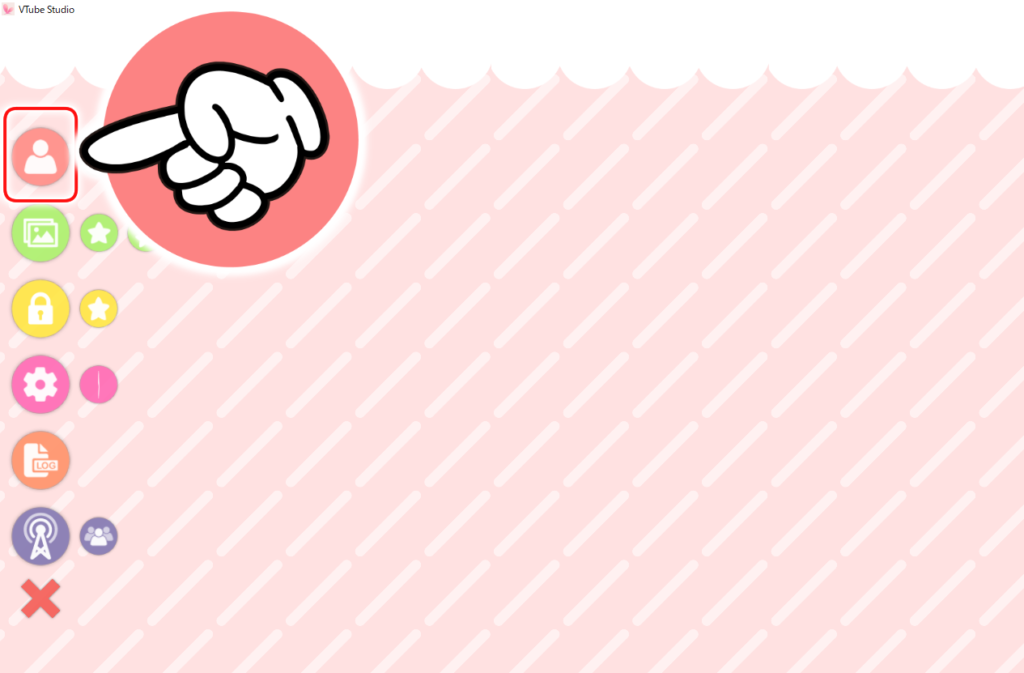

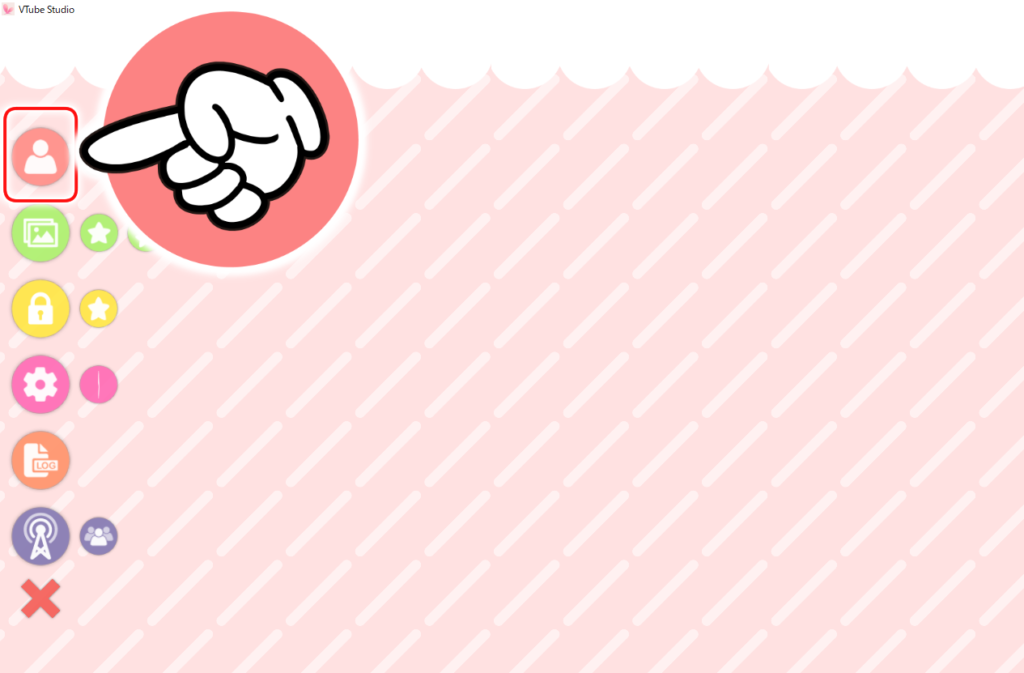

↑起動したら画面左上にある人型のアイコンをクリックします。※メニュー欄がない場合は画面上でダブルクリックすると出てきます。

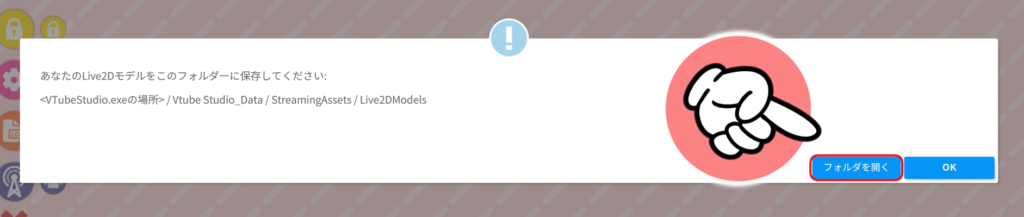

↑画面下にVTube Studio内に入っているモデル一覧が出てきますので、左下にある『自分のモデルをインポート』を選択して下さい。

↑こんな感じのウィンドウが出てくるので右下にある『フォルダを開く』ボタンを押して下さい。

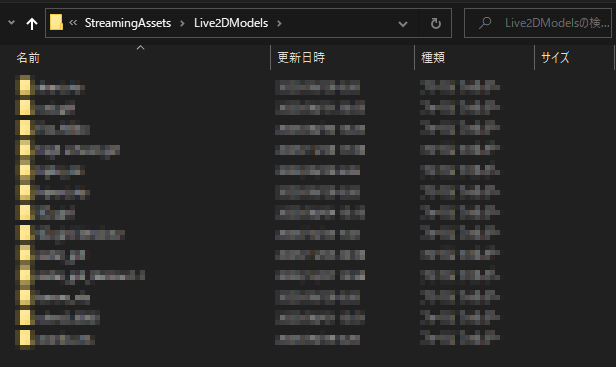

↑モデルのファイルを格納している『Live2DModels』フォルダが表示されますので、その中に購入したモデルを入れていきます。

↑とりあえず、今回は例としてこちらの私が作ったモデルを使っていく事にします。※nizimaの販売ページはこちら。

nizimaやBOOTHで購入したモデルはZIPとかで圧縮されてますので、適当に各々の解凍ソフトを使ってファイルを解凍して下さい。

↑DLしてきたファイルを解凍すると、多分こんな感じの内容物になっているんじゃないかと思います。

この内容物を全て先程表示させた『Live2DModels』フォルダに入れれば導入完了ですが、このまま11個のファイルを個別に入れるとエラーを吐いてモデルの導入ができませんので注意して下さい。

試しに入れてみたら私の環境だとVTube StudioがフリーズしてPCを再起動しないといけなくなったり、全くモデルが反映されなかったりしましたので、やらない方が良いでしょう。

どうやら、ひとまとめにしたフォルダじゃないと認識されないようです。

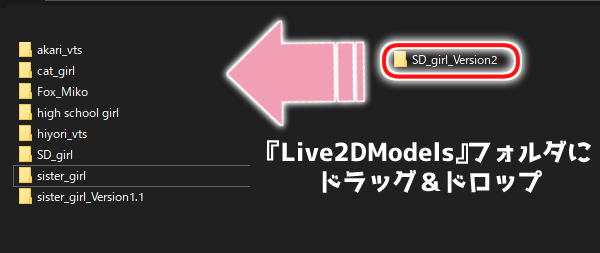

↑って事で、一つ上の階層の『SD_girl_Version2』フォルダを入れていきましょう。

↑『Live2DModels』フォルダに導入したいモデル(ひとまとめになっているフォルダ)をドラッグ&ドロップで入れて下さい。※コピペでコピーしても大丈夫です。

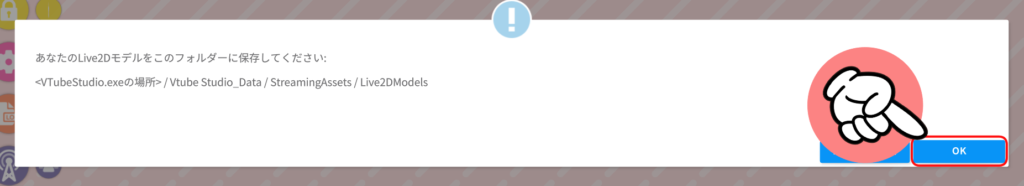

↑あとはVTube Studioに戻って右下のOKボタンを押せば完了です。

↑あとは先程と同じように画面左上にある人型のアイコンをクリックします。

↑画面下にVTube Studio内に入っているモデル一覧が出てきますので、その中に新しいモデルが表示されていれば導入成功です。アイコンをクリックすると画面内にモデルが出てきます。

↑あとは実際に動かしてみて問題なければ導入自体は終了です。

私が作ったモデルに関してはVTube Studio用に調整済みですので、キーボードのショートカットキーを押す事で表情差分を変える事などもすぐに可能となっております。

↑WEBカメラの初期設定などが解らないという方は、こちらの方の動画を参照して頂ければ設定できると思います。

↑iPhoneのカメラを使用したい場合はこちらの方の動画とかを見ると設定可能だと思います。

※私はiPhoneを持ってないので確認できませんが、最新型のiPhoneだとWEBカメラよりも高精度のトラッキングが可能らしいです。

VTube Studioでモデルの動きを調整する方法

一応、私が作ったモデルはVTube Studio用に調整済みではありますが、それは私の環境上(PC&WEBカメラ)でのセッティングとなっておりますので、使用機材&中の人によって多少の微調整が必要な可能性があります。

特に口パクや目パチなんかは結構違うみたいなので、気になる人は再調整してみて下さい。

↑パラメーターの調整をしたい人はこちらの方達の動画とかを見ながらやっていただければ、特に問題なく再調整が行えると思います。

自分の環境や好みに応じて可動域の調整を施して下さい。

体の向きを変更する方法

↑最近の私のモデルの場合、こんな感じで首の動きと体の動きが逆向きになるように設定していたりするのですが、そのあたりを通常の向きに変えたい場合の設定方法を記述しておきます。

↑VTube Studioを起動して設定を直したいモデルを呼び出したら、画面上でダブルクリックしてメニュー欄を表示させ、上から4番目にある歯車マークのアイコンを選択して下さい。

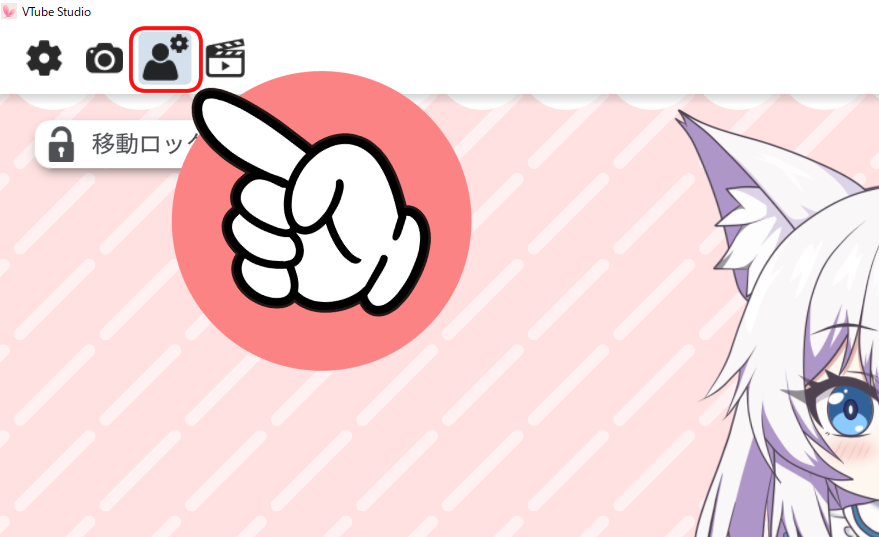

↑次に上部に出てきたメニュー欄の右から2番目にある人型のアイコンを選択して下さい。

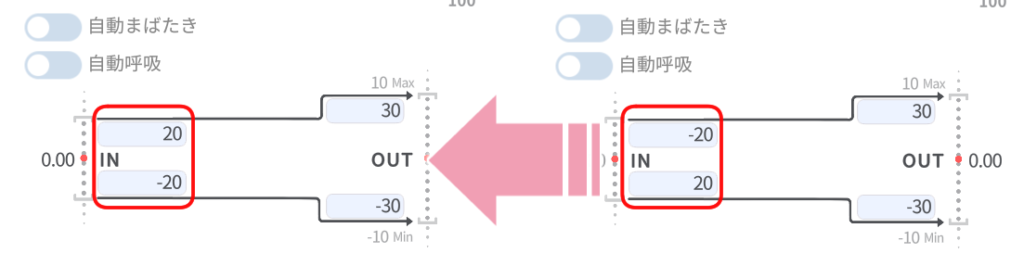

↑右側のパラメーターの欄を下の方にスクロールしていくと『Body Rotation X』という項目がありますので、そちらの数値を変更していきましょう。

↑こんな感じで、IN側の数値をOUT側と同じプラスマイナスの方向に合わせると体の向きと首の向きが一致するようになります。

↑こんな感じで首と体の向きが同じ方向を向くようになりました。

この辺は人の好みというものがありますので、こっちの方が良いという人は再調整してみて下さい。

両目のまばたきの動きを同期させたり、解除したりする方法

前にお問い合わせでモデルの両目が見本の動画みたいに同期していないのですが、どうしたらいいですかといった質問がありましたので、VTube Studio上で両目のまばたきの動きを同期させて、同じように動かす方法と解除する方法を備忘録がてら記述しておきます。

↑VTube Studioを起動して設定を直したいモデルを呼び出したら、画面上でダブルクリックしてメニュー欄を表示させ、上から4番目にある歯車マークのアイコンを選択して下さい。

↑次に上部に出てきたメニュー欄の左から2番目にあるカメラ型のアイコンを選択して下さい。

右側に出てきた一覧を下の方にスクロールするとトラッキング設定の欄がありますので、その中にある『両目同時化』の所にある『常に両目同時にする』にチェックを入れると両目のまばたきが同期するようになります。

↑こんな感じで両目のまばたきが同じように出来るようになります。ただ、デメリットとして片目だけつぶるウィンクとかがトラッキングで出来なくなる点が挙げられますね。

※私の作ったモデルの場合はキーバーインドでウィンクをする仕様で作っていますので、両目のまばたきが同期していてもウィンク可能です。

↑両目を個別に動かしたい場合は先程のトラッキング設定から『両目同時化』の所にある『両目同時にしない』にチェックを入れて下さい。

↑こんな感じで両目のまばたきがバラバラにする事が可能となります。

デメリットとしては両目の動作が安定しないで個別にグラグラ動くので、そのあたりに違和感を覚えるという人は使わない方がいいかも知れません。

大体のVTuberの人は両目のまばたきを同期しているみたいなので、こだわりがあって人力でウィンクとかしたい人以外は同期をしたままでも良いんじゃないかと思います。

が、そのあたりは個人の趣味というものがありますので好きに設定して下さいませ。

VTube Studioで自分好みのキーバインドを作る方法

最後はVTube Studioで既存のパラメーターを組み合わせて新しいキーバインドを作る方法を記述しておきましょう。

↑VTube Studioを起動して設定をしたいモデルを呼び出したら、画面上でダブルクリックしてメニュー欄を表示させ、上から4番目にある歯車マークのアイコンを選択して下さい。

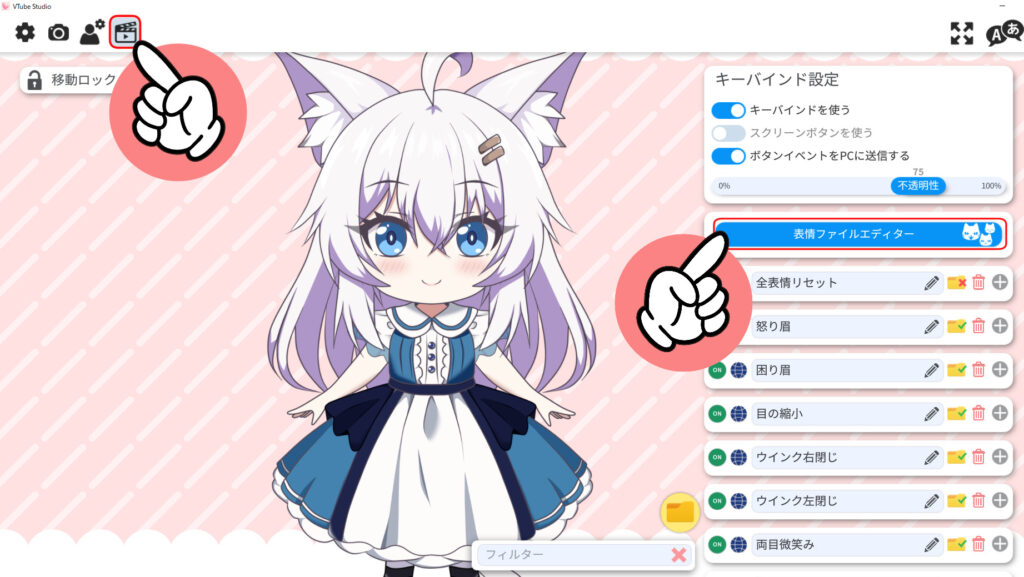

↑次に上部に出てきたメニュー欄の1番右側にあるカチンコ型のアイコンを選択→右側の一覧にある『表情ファイルエディター』を選択して下さい。

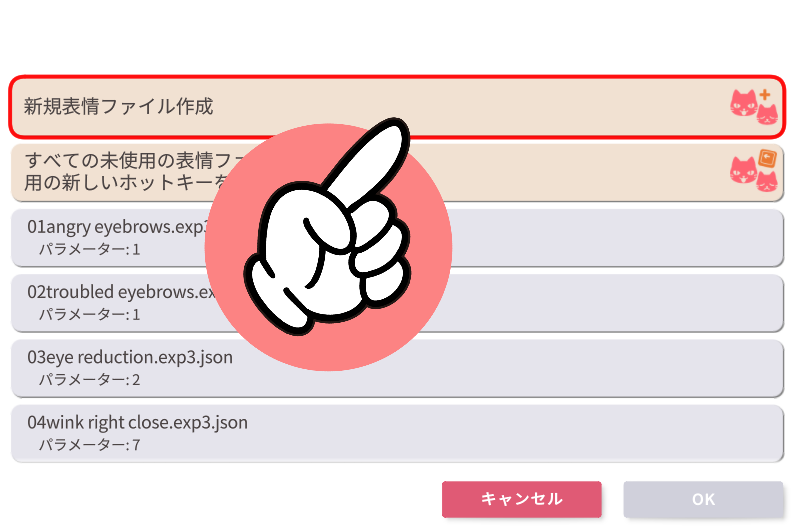

↑画面中央にウィンドウが出てきますので、一番上の『新規表情ファイル作成』を選択して右下にあるOKを押して下さい。

↑画面右側にそのモデルのパラメーター一覧が表示されますので、こちらから目当ての項目を操作して新しいキーバインドを作っていこうと思います。

使用するパラメーターは幾つでも可能なんですが、とりあえずサンプルという事で2個くらいを組み合わせてみましょう。

↑こんな感じで目当てのパラメーターを開き、スライダーで変化具合を設定します。上記のサンプルだとキラキラ目とデフォルメ頬を同時に出現するようにしています。

↑次に一番上の欄にある表情ファイル名に解りやすい名前を入力し、右下にある『保存する』ボタンを押せば新規表情ファイルが生成されます。

あとは、この表情ファイルにキーバインドを設定していきましょう。

↑右側にある表情ファイル一覧を一番下までスクロールすると+マークがありますので、そちらを選択して下さい。

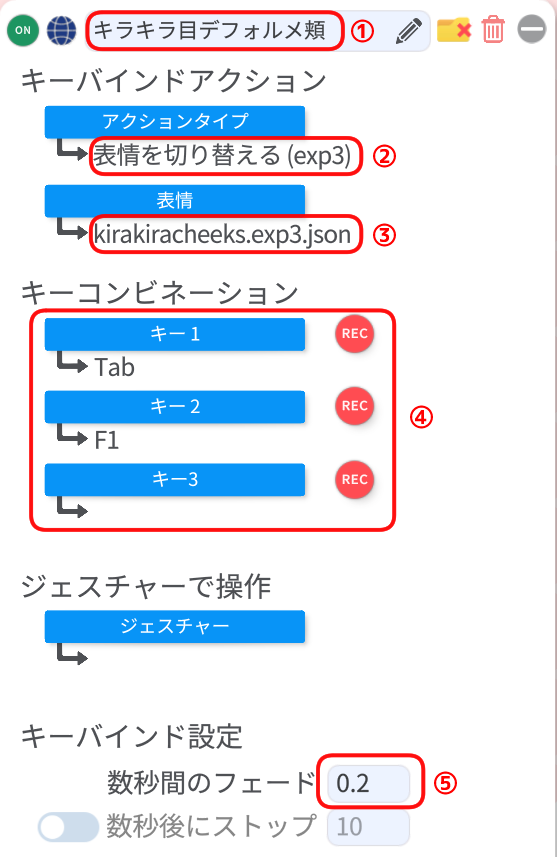

↑設定項目が色々と出てきますので、そちらを設定していきましょう。

①好きなキーバインド名を入力して下さい。解りやすいものが良いと思います。

②アクションタイプは『表情を切り替える』を選択して下さい。

③表情は先程生成した表情ファイル名のものを選択して下さい。

④キーコンビネーションは好きなキーボードのキーの組み合わせを選択して下さい。

※ただし、既に他で設定されている組み合わせだと警告サインが出ます。

⑤キーバインド設定のフェードの秒数は小さいほど早く切り替わります。

数値を大きくするとゆっくり切り替わりますので好きなように設定して下さい。

↑あとはこの状態で設定したキーを押してみて正常に動作すれば終了です。

こんな感じで任意のパラメーター同士を掛け合わせて好きな表情ファイルを作っていって下さい。

以上です。

では、本日はここまで。

次項もお時間のある方は読んでいって下さいませ。

↑Live2Dのサブスク購入を御検討の方はこちらからどうぞ。

新規でブログを作りたい方はこちらのレンタルサーバーがお薦めです。⇒≪新登場≫国内最速・高性能レンタルサーバー【ConoHa WING】

動画編集、3Dモデリング用のパソコンをお求めの方はこちらがお薦めです。⇒BTOパソコンのサイコム

今回の記事作成時間&経費&日記

記事作成時間:約6時間

おかげさまで、ようやくLive2Dモデルの販売が始める事ができました。

いや~、予想以上に難航しましたわ。

企画開始直後から高熱を出して寝込んでLive2Dのサブスク代が一か月くらい無駄になったり、販売直前になって物理演算について師匠達からダメ出しされて調整地獄になったり、本業の関係で3つ資格を取ってこいという指令が来て勉強漬けになったりと色々とありましたが、なんとか世に出せるようになって良かったです。

さて、これからの予定ですが。

これを書いている時点では6作目のLive2Dモデルのイラストをダラダラと組み立てている途中だったりしますね。

まあ、そちらは『基本機能以外は最低限のギミックのみ搭載した廉価版の一点もの』というお題で作っていますので、完成までにそんなに時間はかからないんじゃないかと思います。

廉価版を作っている理由としては、安いモデルの一点ものなら売れるのかという検証の為だったりします。

基本的に私が作ったモデルの値付けは師匠達がやっているんですが、かかった製作時間&完成度を考慮した価格となっているらしく、初期のモデルとかは完成度に反して製作時間が相当にかかっているせいで高額になっていたりするんですよね。

なので、今まで作った限定一点のモデルは未だに売れてなかったりします。

まあ、今までのモデルはノウハウ蓄積の為に色々な機能を実装してみた趣味的なものだったりするので、別に売れなくても私は気にしないんですが、個人的な興味として1体くらいは限定一点ものを完売してみたいという事で6体目の製作をする事になった次第ですね。

多分、今の技術なら5日~7日くらいあればイラスト込みでギミックが少ないモデルなら作れるので、今までよりも安価に提供できるんじゃないかと思います。

最も、現在取得中の資格の勉強が優先されますので、実質2~3週間くらいはかかるんじゃないかと予測していますが。

とりあえず、2023年内での完成を目指してみましょう。

次に、6体目が無事に完成したら、7体目以降は量産化を前提としたモデル作成を目指す事になりますので、そこそこ高機能な汎用素体の作成に入る予定です。

3Dモデルとかでも汎用素体を作って、それを調整して様々なモデルを作るのが定石となっておりますので、それをLive2Dでやってみようという訳ですね。

調べた限りではLive2Dで汎用素体を作っている人はあんまり居ないようなので、何かしらの落とし穴がある可能性も否めませんが。

ともあれ、一応ノウハウの蓄積がてら試せるだけ試してみようと思います。

上手くいけばゼロからモデルを作るよりも超大幅な作業時間短縮&モーションの共有などを始めとした最適化ができるようになりますからね。

では、最後に恒例の累計出費&記事作成時間を発表して終わりにしましょう。

総制作時間:約2556時間

累計支出:97,242円